flowchart LR X[Datos X1,..., Xn] --> T1(Estimador T1) X[Datos X1,..., Xn] --> T2(Estimador T2) X[Datos X1,..., Xn] --> T3(Estimador T3) T1 --> TMLE(MLE) T2 --> TMLE(MLE) T3 --> TMLE(MLE) TMLE --> P([Parámetro])

6 Estadísticos suficientes y criterio de factorización

6.1 Estadísticos suficientes

Un estadístico se considera “suficiente” con respecto a un parámetro desconocido si contiene toda la información en la muestra sobre ese parámetro. En otras palabras, una vez que se conoce el valor del estadístico suficiente, el resto de los datos no proporciona información adicional sobre el parámetro en cuestión.

Para entenderlo de manera más formal: consideremos una muestra y un parámetro \(\theta\). Un estadístico \(T=r(X_1, \dots, X_n)\) es suficiente para \(\theta\) si la distribución condicional de la muestra, dado el valor de \(T\), no depende de \(\theta\). Esto significa que, independientemente del valor real de \(\theta\), la distribución de la muestra no cambiará una vez que se conozca \(T\).

Definición 6.1 Sea \(X_1,\dots,X_n\) una muestra indexada por \(\theta\). Un estadístico \(T\) es suficiente si, para cada \(\theta \in \Omega\) y para cada \(t\) en la imagen de \(T\), la distribución condicional de \(X_1,\dots,X_n|T=t\) no depende de \(\theta\).

6.2 Teorema de factorización de Fisher

El teorema de factorización proporciona una caracterización de los estadísticos suficientes a través de la factorización de la función de verosimilitud.

Teorema 6.1 (Factorización de Fisher) Si \(X_1,\dots,X_n\) es una muestra aleatoria de \(f(x|\theta)\), el parámetro \(\theta\) es desconocido. Un estadístico \(T=r(X_1,\dots,X_n)\) es suficiente si y solo si \[\begin{equation*} f_n(X|\theta) = u(X)v(r(X),\theta)\;\forall x\in \mathbb{R}, \; \forall \theta \in \mathbb{R}. \end{equation*}\]

Observación. En el caso bayesiano tenemos que si \(f_n(x|\theta) \propto v(r(x),\theta)\) (\(u(x)\) es una constante con respecto a \(\theta\)), se obtiene que: \[ \pi(\theta|x) \propto \pi(\theta)v(r(x),\theta).\]

Por lo tanto, un estadístico \(r(x)\) es suficiente si y solo si no importa cuál previa de \(\theta\) se use, la posterior depende solamente de \(r(x)\) a través de los datos.

Ejemplo 6.1 Sean \(X_1,\dots, X_n \sim \text{Poisson}(\lambda)\),

\[\begin{align*} f_n(X|\theta) & = \prod_{i=1}^n \dfrac{e^{-\lambda}}{X_i!} \\ & = \dfrac{e^{-\lambda n} \lambda ^{\overbrace{\sum_{i=1}^{n} X_i}^{r(X)}}}{\prod X_i!} \\ & = \underbrace{\dfrac{1}{\prod_{i=1}^n X_i!}}_{u(x)} \underbrace{e^{-\lambda n}\lambda^{r(X)}}_{v(r(X),\lambda)} \end{align*}\]

Si \(X_i < 0\) para al menos un \(i\), entonces \(f_n(X|\theta) = 0\). Tome \(u(X) = 0\).

Por el teorema de factorización, \(r(X) = \sum_{i=1}^{n} X_i\) es un estadístico suficiente para \(\lambda\).

Ejemplo 6.2 Sea \(X_1,\dots, X_n \sim f(x|\theta)\) donde \[ f(x|\theta) = \begin{cases}\theta x^{\theta-1} & 0<x< 1\\ 0 & \text{otro caso}\end{cases}\]

Si \(0<X_i<1\) para todo \(i\), entonces la verosimilitud se escribe como,

\[\begin{align*} f_n(X|\theta) & = \theta^n\bigg[\underbrace{\prod(X_i)}_{r(X)}\bigg]^{\theta-1} \\ & = \underbrace{\theta^n(r(X))^{\theta-1}}_{v(r(X),\theta)}\cdot \underbrace{1}_{u(x)} \end{align*}\]

Por el teorema de factorización \(r(X) = \prod_{i=1}^{n} X_i\) es un estadístico suficiente para \(\theta\).

Ejemplo 6.3 Sea \(X_1,\dots, X_n \sim N(\mu, \sigma^2)\).

\[\begin{align*} f_n(X|\theta) & = (2\pi\sigma^2)^{-n/2} \exp\bigg[-\dfrac{1}{2\sigma^2}\sum_{i=1}^n(X_i-\mu)^2\bigg] \\ & = (2\pi\sigma^2)^{-n/2} \exp\bigg[-\dfrac{1}{2\sigma^2}\underbrace{\sum_{i=1}^n X_i^2}_{r_2(X)}+ \dfrac{\mu}{\sigma^2}\underbrace{\sum_{i=1}^n X_i}_{r_1(X)} - \dfrac{\mu^2 n}{2\sigma^2} \bigg] \end{align*}\]

Considere el caso \(\sigma^2\) conocido. Tome \[\begin{align*} u(X) & = (2\pi\sigma^2)^{-n/2}\exp\bigg[-\dfrac{1}{2\sigma^2} \displaystyle\sum_{i=1}^n X_i^2\bigg], \\ v(r_{1}(X),\mu) & = \exp\bigg[\dfrac{\mu}{\sigma^2}r_{1}(X) - \dfrac{n\mu^2}{2\sigma^2}\bigg]. \end{align*}\] Por teorema de factorización, \(r_{1}(X)=\sum_{i=1}^{n} X_i\) es un estadístico suficiente para \(\mu\).

Con \(\sigma^2\) desconocido, entonces los parámetros son \(\theta = (\mu,\sigma^2)\). Tome \(u(X) = 1\), \[ v(r_1(X),r_2(X),\theta) = (2\pi\sigma^2)^{-n/2}\exp\bigg[\dfrac{-r_2(X)}{2\sigma^2} + \dfrac{\mu r_1(X)}{\sigma^2}- \dfrac{n\mu^2}{2\sigma^2}\bigg] \] Entonces \[ (r_1(X),r_2(X)) = \left(\sum_{i=1}^{n}{X_i},\sum_{i=1}^{n} x_i ^2\right) \] es un estadístico suficiente para \((\mu, \sigma^2)\).

Ejemplo 6.4 Sea \(X_1,\dots, X_n \stackrel{i.i.d}{\sim}\text{Unif}(0,\theta)\), \(\theta>0\), donde \(f(x|\theta) = \frac{1}{\theta} 1_{[0,\theta]}(x)\). Entonces la verosimilitud es,

\[f_n(X|\theta) = \prod_{i=1}^n \left(\dfrac 1\theta \right) 1_{[0,\theta]}(X_i) \]

Tenemos varios casos a considerar:

Si al menos uno de los \(X_i<0\) o \(X_i>\theta\), tome \(u(X) = 0\) y por lo tanto \(f(X|\theta) = 0\).

Si \(0<X_i<\theta\) para todo \(i\), entonces \[\begin{equation*} f_n(X|\theta) = \left(\dfrac 1\theta \right)^{n} 1_{[0,\theta]}(X_{(n)}). \end{equation*}\] Donde \(X_{(n)} = \max\{X_1, \dots, X_n\ \). Ahora si \(T = r(X) = X_{(n)}\) entonces \(f_n(X|\theta) = u(X)v(r(X),\theta)\), \(u(X) =\). Por teorema de factorización, \(r(X) = X_{(n)}\) es un estadístico suficiente para \(\theta\).

6.3 Estadístico suficiente multivariado

El concepto de suficiencia se puede extender a múltiples parámetros. En este caso si \(\theta \in \mathbb{R}^{k}\) con \(k \geq 1\), se necesita al menos \(k\) estadísticos \(T_{1}, \dots, T_{k}\) para cada \(i = 1, \dots, k\), de modo que \(T_{i} = r_{i}(X_{1}, \dots, X_{n})\).

Definición 6.2 Un conjunto de estadísticos \((T_1,\dots,T_k)\) es suficiente para el parámetro \(\theta\in\mathbb{R}^{k}\) si, para cada \(\theta\) y para cada conjunto de valores \((t_1,\dots,t_k)\) en \(\mathbb{R}^k\), la distribución condicional de la muestra \(X_1,\dots,X_n\) dado que \((T_1,\dots,T_k)=(t_1,\dots,t_k)\) no depende de \(\theta\).

Teorema 6.2 (Criterio de factorización multivariado) Bajo las condiciones anteriores, entonces \(f_n(x|\theta) = u(x)v(r_1(x),\dots,r_k(x),\theta)\) si y solo si \(T = (r_1(x),\dots,r_k(x))\) es suficiente.

Corolario 6.1 Si \((T_1,\dots,T_k)\) es suficiente para \(\theta\) y si \((T_1',\dots,T_k') = g(T_1,\dots,T_k)\) donde \(g\) es biyectiva, entonces \((T_1',\dots,T_k')\) es suficiente para \(\theta\).

Ejemplo 6.5 Consideremos una muestra \(X_1,\dots,X_n\) de una distribución normal \(N(\mu,\sigma^2)\). En ejemplos previos, determinamos que los siguientes estadísticos son suficientes para \(\mu\) y \(\sigma^2\):

\[\begin{align*} T_1 & = \sum_{i=1}^{n} X_i \\ T_2 & = \sum_{i=1}^{n} X_i^2 \\ \end{align*}\]

Si aplicamos un procedimiento similar para la distribución normal bivariada, encontramos que la verosimilitud puede factorizarse en términos de \(T_1\) y \(T_2\). Por lo tanto, \((T_1,T_2)\) son conjuntamente suficientes para \((\mu,\sigma^2)\).

Considerando otro conjunto de estadísticos: \[\begin{align*} T_1^{\prime} & = \frac{1}{n} \sum_{i=1}^{n} X_i \\ T_2^{\prime} & = \frac{1}{n} \sum_{i=1}^{n} (X_i - \bar{X}_n) ^{2} \end{align*}\]

Entonces defina la siguiente función \[ (T_1',T_2') = g(T_1,T_2) = \left(\dfrac{1}{n}T_1,\dfrac{1}{n}T_2 - \dfrac{1}{n^2}T_1^2\right). \]

De la primera entrada, \[\begin{align*} T_1^{\prime} = \dfrac 1n T_1 \\ \end{align*}\] De la segunda, \[\begin{align*} \frac{1}{n} T_2 - \frac{1}{n^2}T_1^2 & = \dfrac 1n \sum X_i^2 - \left(\dfrac 1n \sum X_i\right)^2 \\ & = \dfrac 1n \sum X_i^2 - 2X_i \overline{X}_n^2 + \overline{X}_n \\ & = \dfrac 1n \sum(X_i-\overline{X}_n)^2 = T_2^{\prime} \end{align*}\]

Es decir, tenemos las relaciones

\[\begin{align*} T_1 & = n\ T_1^{\prime} \\ T_2 & = n\left(T_2^{\prime} + {T_1^{\prime}}^2\right) \end{align*}\]

Entonces, note como se puede expresar \((T_{1}, T_{2})\) en términos de \((T_1^{\prime}, T_2^{\prime})\) y viceversa. Por lo tanto \(g\) es biyectiva.

Finalmente \((T_1^{\prime}, T_2^{\prime})\) son estadísticos suficiente conjuntos para \((\mu,\sigma^2)\).

Ejemplo 6.6 Considere una muestra \(X_1,\dots,X_n\) de una distribución uniforme \(Unif(a,b)\) con \(a<b\). Queremos determinar un estadístico suficiente para \(a\) y \(b\) conjuntamente.

- Si algún \(X_i < a\) o \(X_i>b\), tome \(u(x) = 0\).

- Si \(a\leq X_i \leq b\) para todo \(i\),

Si \(X_i \geq a\) para todo \(i\) entonces \(X_{(1)}>a\).

\(X_i \leq b\) para todo \(i\) entonces \(X_{(n)}<b\).

La verosimilitud es de la forma

\[\begin{align*} f_n(x|(a,b)) & = \prod_{i=1}^n\frac{1}{(b-a)}1_{[a,b]}(x_i) \\ & = \underbrace{\frac{1}{(b-a)^n} 1_{\{(z,w): z>a, w<b\}}(X_{(1)},X_{(n)})}_{v(r_1(x),r_2(x),(a,b))}\cdot \underbrace{1}_{u(x)} \end{align*}\]

Por teorema de factorización \((r_{1}(x), r_{2}(x)) = (X_{(1)},X_{(n)})\) es un estadístico suficiente para \((a,b)\).

6.4 Estadísticos minimales

En inferencia estadística, el objetivo principal es resumir la información contenida en una muestra. Mientras que un estadístico suficiente encapsula toda la información necesaria sobre un parámetro, un estadístico minimal proporciona la representación más simple y reducida de esa información.

¿Qué significa realmente “minimal”?

Recordemos que el espacio muestral \(\mathcal X\) es el conjunto de todos los posibles resultados de un experimento aleatorio. Supongamos que podemos organizarla en “paquetes” de información. Un estadístico minimal es aquel que contiene la menor cantidad de “paquetes” posible sobre el o los parámetros de interés.

Comencemos entiendo la peor forma de empaquetar nuestra información.

Definición 6.3 (Estadístico de orden) Sean \(X_1,\dots, X_n \stackrel{i.i.d}{\sim} f\). Se denominan los estadísticos de orden a las variables aleatorias ordenadas de la forma

\[(Y_1,\dots,Y_n) = (X_{(1)},\dots,X_{(n)}) \text { tal que } Y_1<\dots<Y_n.\]

Teorema 6.3 Para una muestra aleatoria \(X_1,\dots,X_n\) con densidad \(f(x\vert\theta)\), el conjunto \((X_{(1)},\dots,X_{(n)})\) es un estadístico conjuntamente suficiente para \(\theta\).

Ejemplo 6.7 Consideremos una muestra \(X_1, \dots X_n\) de una distribución Cauchy con parámetro de localización \(\alpha\). La función de densidad es

\[ f(x) = \dfrac1\pi(1+(x-\alpha)^2)^{-1}, x\in\mathbb{R}\]

Para encontrar un estimador suficiente para \(\alpha \in \mathbb{R}\), calculamos lo siguiente:

\[\begin{align*} f_n(X|\alpha) & = \prod_{i=1}^{n} f(X_i|\alpha) \\ & =\dfrac 1\pi (1+(X_i-\alpha)^2)^{-1} \\ & =\frac{1}{\pi^n}\prod_{i=1}^n(1+(X_i-\alpha)^2)^{-1} \\ & = \underbrace{\dfrac 1{\pi^n}}_{u(X)} \underbrace{\left(\left(1+(X_{(1)}-\alpha)^2\right)^{-1}\right) \cdots \left(\left(1+(X_{(n)}-\alpha)^2\right)\right)}_{v(y,\alpha)} \end{align*}\] donde \(y = (X_{(1)},\dots,X_{(n)})\) es suficiente para \(\alpha\).

Ejercicio 6.1 Estime \(\alpha\) de las siguientes dos formas:

- Usando el método de momentos.

- Escribiendo el código de la log-verosimilitud y maximizándola usando la función

optimenR.

Definición 6.4 Un estadístico \(T\) es suficiente minimal si \(T\) es suficiente y es función de cualquier otro estadístico suficiente.

Teorema 6.4 Si \(T = r(X_1,\dots, X_n)\) es un estadístico suficiente para \(\theta\), entonces el MLE \(\hat\theta\) de \(\theta\) depende de \(X_1,\dots, X_n\) solamente a través de \(T\). Además, si \(\hat \theta\) es suficiente entonces \(\hat \theta\) es minimal.

Teorema 6.5 Si \(T = r(X_1,\dots, X_n)\) es un estadístico suficiente para \(\theta\) entonces el estimador bayesiano (bajo una escogencia de \(L\)) depende de \(X_1,\dots, X_n\) solamente a través de \(T\) (el estimador bayesiano es minimal).

Observación. En otras palabras, minimalidad significa que la única forma de resumir la información de la muestra para obtener un estimador es a través de un estadístico suficiente que además sea MLE. Cualquier otro estimador, es simplemente una función del MLE.

6.5 Mejorando estimadores

¿Será posible mejorar un estimador que no es suficiente?

¿Existirá otra medida de comparación entre estimadores?

Considere una función de riesgo o pérdida \[ R(\theta,\delta) = \mathbb E[(\delta(x)-\theta) ^2]\] Si \(\delta(x)\) estima una característica de \(F\): \[ R(\theta,\delta) = \mathbb E[(\delta(x)-h(\theta))^2] \tag{6.2}\] donde \(h\) es la característica.

Observación. La función de riesgo puede ser calculada con una posterior \(\pi(\theta|X)\).

Definición 6.5

- Decimos que \(\delta\) es inadmisible si \(\exists \delta_0\) (otro estimador) tal que \(R(\theta, \delta_{0}) \leq R(\theta,\delta)\) \(\forall \theta \in \Omega\).

- Decimos que \(\delta_0\) “domina” a \(\delta\) en el caso anterior.

- Decimos que \(\delta_0\) es admisible si no existe otro estimador que domine a \(\delta_0\).

- A Ecuación 6.2 se le llama MSE o error cuadrático medio.

Teorema 6.6 (Rao-Blackwell) Sea \(\delta(X)\) un estimador y \(T\) un estadístico suficiente para \(\theta\) y sea \(\delta_0 = \mathbb E[\delta(X)|T]\) Entonces \[ R(\theta,\delta_0) \leq R(\theta,\delta) \; \forall \theta \in \Omega\]

Observación. Si cambiamos a \(R(\theta,\delta) = \mathbb E[|\delta(x)-\theta|]\) (error medio absoluto), el resultado anterior es cierto.

Ejemplo 6.8 Sean \(X_1,\dots, X_n \stackrel{i.i.d}{\sim} \text{Poisson}(\theta)\) donde \(\theta\) es la tasa de “visitas” de clientes por hora.

Defina el caso donde solo nos interesa si hay una visita por hora.

Podemos escribir la v.a como \(Y_i = \begin{cases} 1 & \text{si } X_i = 1\\ 0 & \text{si } X_i \ne 1\end{cases}\).

En este caso, tenemos que para una Poisson \(\text{Poisson}(\theta)\), \(\mathbb{P}(X_i = 1) = \theta e^{-\theta}\).

Si suponemos que \(\theta=2\), entonces el parámetro de interés es \(p = \mathbb{P}(X_i = 1) = 2e^{-2}=0.2707\).

El objetivo es encontrar un estimador de \(p\) que sea lo más cercano a \(0.2707\).

Numéricamente podemos hacer el ejemplo con una muestra de \(n = 20\),

Código

set.seed(42)

x <- rpois(n = 20, lambda = 2)

head(x, 20) [1] 4 4 1 3 2 2 3 0 2 3 2 3 4 1 2 4 5 0 2 2Código

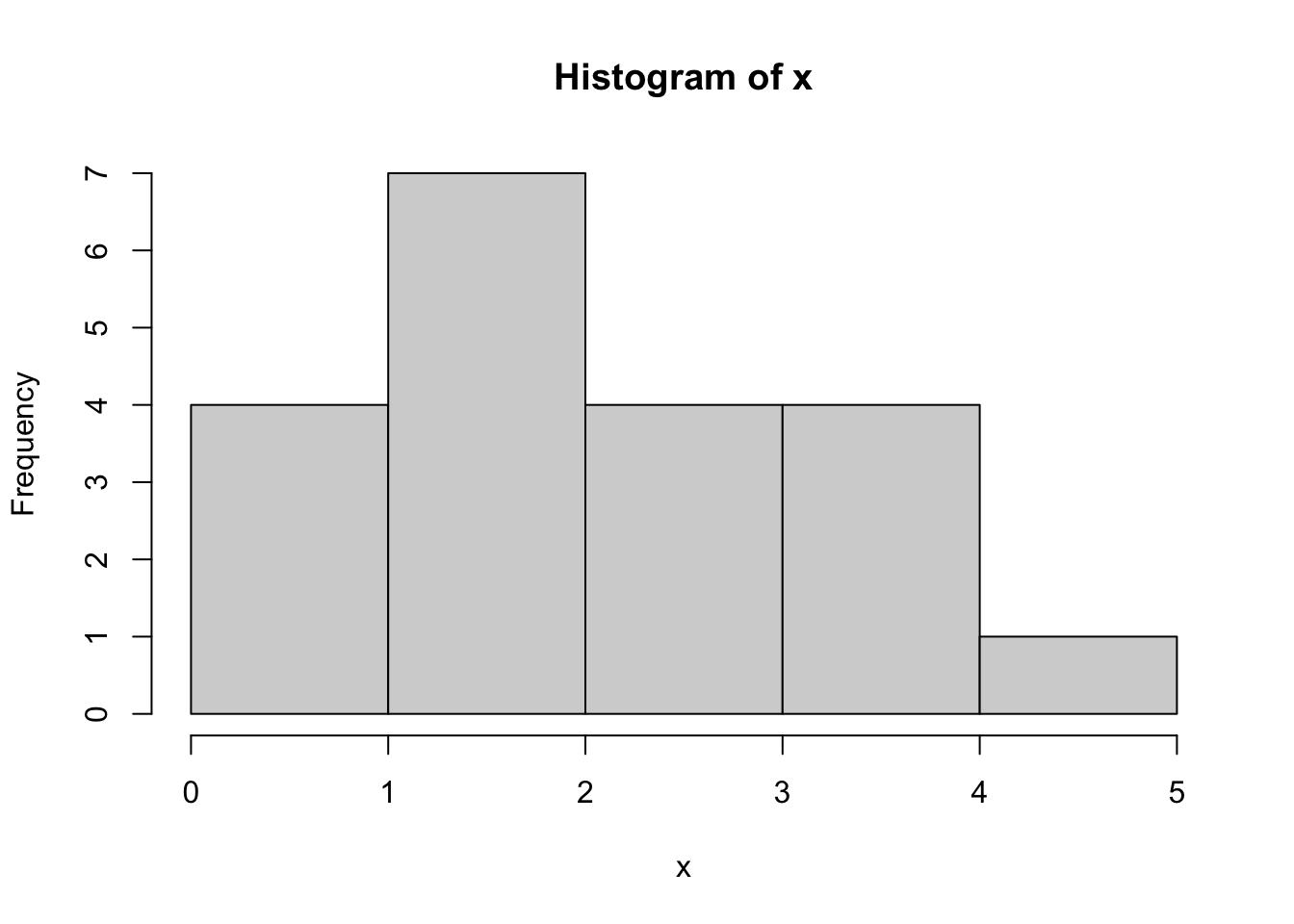

hist(x)

A partir de la verosimilitud, \[f_n(X|\theta) = \dfrac{e^{-\theta n} \theta^{\sum_{i=1}^{n} X_i}}{\prod_{i=1}^{n} X_i!} \] se tiene que \(T=\sum_{i=1}^{n} X_i\) es un estadístico suficiente para \(\theta\).

Esta \(Y\) se calcula de la forma

Código

y <- x == 1

head(y, 5)[1] FALSE FALSE TRUE FALSE FALSEEl objetivo es estimar \(p\) donde \(p\) es la probabilidad de que \(X_i =1\) (solo llegue un cliente por hora). Un estimador de \(p\) (MLE) es \[\delta(x) = \dfrac{\sum_{i=1}^{n} Y_i}{n}\]

Código

(delta <- mean(y))[1] 0.1¿Este estimador \(\delta\) es lo más óptimo que podemos hacer?

Para esto usaremos el teorema de Rao-Blackwell. Entonces calculamos \[\mathbb E[\delta(x)|T] = \dfrac 1n \sum_{i=1}^n \mathbb E (Y_i|T)\] Vea que

\[ \begin{aligned} \mathbb E[Y_i|T = t] & = \mathbb{P}(X_i = 1 \vert T = t) \\ & = \dfrac{\mathbb{P}(X_i = 1, T=t)}{\mathbb{P}(T=t)} \\ & = \dfrac{\mathbb{P}(X_i = 1, \sum_{j\ne i} X_j = t-1)}{\mathbb{P}(T=t)} \\ & = \dfrac{\mathbb{P}(X_i = 1) \mathbb{P}(\sum_{j\ne i} X_j = t-1)}{\mathbb{P}(T=t)} \end{aligned} \tag{6.3}\]

Ahora cada componente de la última expresión se puede escribir como

\[ \begin{aligned} \mathbb{P}(X_i = 1) & = \theta e^{-\theta} \\ \mathbb{P}(\sum_{j\ne i}X_j = t-1) & = e^{-(n-1)\theta}\dfrac{((n-1)\theta)^{t-1}}{(t-1)!} \\ \mathbb{P}(T=t) & = e^{-n\theta}\dfrac{(n\theta)^t}{t!} \end{aligned} \tag{6.4}\]

Entonces, uniendo Ecuación 6.3 y Ecuación 6.4 se tiene que, \[\begin{align*} \mathbb E[Y_i|T = t] & = \dfrac{\theta e^{-n\theta}\dfrac{((n-1)\theta)^{t-1}}{(t-1)!}}{e^{-n\theta}\dfrac{(n\theta)^t}{t!}} \\ & = \dfrac tn \left(1-\dfrac 1n\right)^{t-1} \end{align*}\]

es el estadístico con MSE mínimo.

Código

est_suficiente <- sum(x)

n <- length(x)

(delta_0 <- (est_suficiente / n) *

(1 - 1 / n)^(est_suficiente - 1))[1] 0.2088811En este caso \(\delta_0\) es mejor que \(\delta\) bajo una pérdida cuadrática.

Solo para comprobar, note que si tuviéramos una muestra grande los dos resultados serían similares

Código

set.seed(42)

x_10000 <- rpois(n = 10000, lambda = 2)

y_10000 <- x_10000 == 1

(delta <- mean(y_10000))[1] 0.268Código

est_suficiente <- sum(x_10000)

n <- length(x_10000)

(delta_0 <- (est_suficiente / n) *

(1 - 1 / n)^(est_suficiente - 1))[1] 0.2716586